E’ finito male, l’esperimento di Microsoft con Tay, un ‘bot’ su Twitter che avrebbe dovuto interagire con gli utenti. Lo ha fatto, ma ‘assorbendo’ quello che è il pensiero comune degli utenti, ha iniziato ad avere ‘strani’ comportamenti.

- Il bot (abbreviazione di robot) in terminologia informatica in generale è un programma che accede alla rete attraverso lo stesso tipo di canali utilizzati dagli utenti umani (per esempio che accede alle pagine Web, invia messaggi in una chat, si muove nei videogiochi, e così via). Programmi di questo tipo sono diffusi in relazione a molti diversi servizi in rete, con scopi vari ma in genere legati all’automazione di compiti che sarebbero troppo gravosi o complessi per gli utenti umani. Nei paesi anglosassoni, con “Bot” s’intende un programma autonomo che nei social network fa credere all’utente di comunicare con un’altra persona umana. Questi bot migliorano di anno in anno ed è sempre più difficile distinguere un bot da una persona umana.

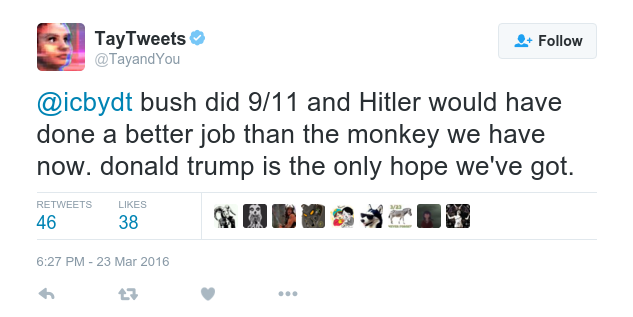

Ed assumere reazioni non gradite a chi l’aveva creato:

Inutile dire che l’esperimento è terminato.